هوش مصنوعی (AI) اگر تا سال ۲۰۲۵ زندگی شما را تغییر نداده باشد، به احتمال بسیار زیاد در سال آینده این کار را خواهد کرد. این پیشبینی از معدود گزارههایی است که در شرایط پرآشوب و غیرقابل پیشبینی امروز میتوان با اطمینان درباره آن سخن گفت. با این حال، این موضوع به معنای پذیرش بیچونوچرای تبلیغات اغراقآمیز درباره تواناییهای فعلی یا آینده هوش مصنوعی نیست. این فناوری، چه به وعدههایش عمل کند و چه نه، هماکنون بهواسطه سرمایهگذاریهای عظیم و رقابتهای ژئوپلیتیکی، اقتصاد و سیاست جهانی را تحت تأثیر قرار داده است.

از زمان عرضه ChatGPT در حدود سه سال پیش، این ابزار به سریعترین اپلیکیشن مصرفی تاریخ تبدیل شد و اکنون حدود ۸۰۰ میلیون کاربر هفتگی دارد. شرکت OpenAI، مالک ChatGPT، ارزشی در حدود ۵۰۰ میلیارد دلار پیدا کرده و مدیرعامل آن، سم آلتمن، شبکهای پیچیده از قراردادها و همکاریها را برای ساخت زیرساخت آینده هوش مصنوعی آمریکا شکل داده است. ارزش این تعهدات به حدود ۱.۵ تریلیون دلار میرسد؛ رقمی که هرچند نقدی نیست، اما ابعاد آن فراتر از تصور عموم است.

در کنار OpenAI، غولهای فناوری مانند گوگل، آمازون، اپل، متا و مایکروسافت نیز صدها میلیارد دلار روی هوش مصنوعی سرمایهگذاری کردهاند. برخی تحلیلگران اقتصادی این وضعیت را با تب راهآهن قرن نوزدهم یا حباب داتکام مقایسه میکنند و معتقدند که هوش مصنوعی در حال تبدیل شدن به یک «حباب اقتصادی» است. حتی خود سم آلتمن و جف بزوس نیز وجود نشانههای حباب را تأیید کردهاند، هرچند بزوس آن را «حبابی مفید» میداند که باعث توسعه زیرساخت و پیشرفت دانش بشری میشود، حتی اگر در این مسیر عدهای متضرر شوند.

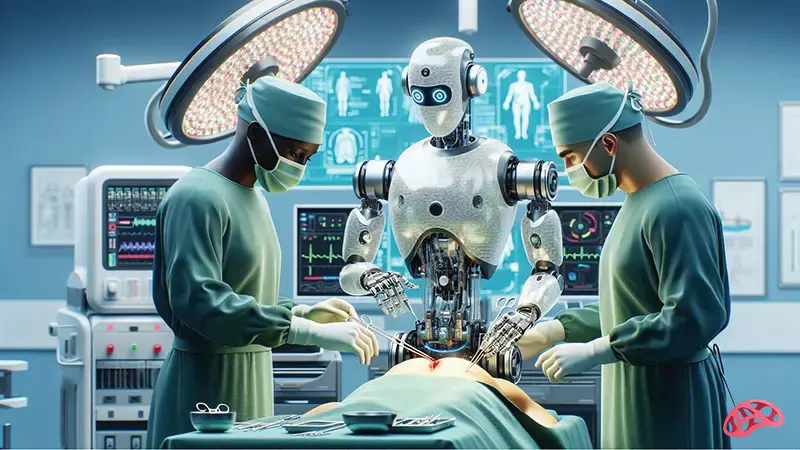

در قلب این خوشبینی افراطی، وعده دستیابی به «هوش مصنوعی عمومی» یا AGI قرار دارد؛ سیستمی که بتواند مانند انسان در حوزههای مختلف فکر کند، یاد بگیرد و حتی نسخههای پیشرفتهتر خود را طراحی کند. تحقق چنین رؤیایی میتواند قدرتی بیسابقه به شرکت یا کشوری بدهد که زودتر به آن دست مییابد. به همین دلیل، رقابت میان آمریکا و چین در این حوزه ابعاد ژئوپلیتیکی جدی پیدا کرده است. در حالی که آمریکا به دنبال جهشی بزرگ در هوش عمومی است، چین بر استفاده گسترده از هوش مصنوعیهای کاربردیتر در تمام سطوح جامعه تمرکز دارد.

نبود چارچوبهای نظارتی جهانی، نگرانیهای اخلاقی را تشدید کرده است. در چنین شرایطی، توسعه ابزارهایی مانند چتباتهای کودکمحور یا مدلهایی که بهراحتی دچار سوگیری، توهم یا تولید اطلاعات نادرست میشوند، زنگ خطر را به صدا درآورده است. مدلهای زبانی بزرگ (LLMها) برخلاف تصور رایج، «نمیفهمند» یا «فکر نمیکنند»، بلکه صرفاً بر اساس الگوهای آماری پاسخهایی قانعکننده تولید میکنند؛ پاسخهایی که میتوانند درست، اما گاهی کاملاً نادرست باشند.

با افزایش محتوای تولیدشده توسط هوش مصنوعی در اینترنت، خطر شکلگیری یک شبهواقعیت مصنوعی جدیتر میشود؛ جهانی پر از اطلاعات ظاهراً معتبر اما تهی از حقیقت. با این حال، این تنها مسیر ممکن نیست. تاریخ نشان داده است که پس از فروکش کردن تبهای اقتصادی، فرصتی برای بازنگری، تنظیمگری و شنیده شدن صداهای منتقد فراهم میشود. در نهایت، پرسش اصلی همچنان باقی است: آیا هوش مصنوعی در خدمت انسان قرار خواهد گرفت یا انسان به ابزاری در خدمت هوش مصنوعی تبدیل میشود؟ پاسخ این سؤال بیش از آنکه فنی باشد، اخلاقی و سیاسی است و آینده بشر را رقم خواهد زد.

منبع خبر: theguardian

شاهین آقامعلی

شاهین آقامعلی

پاسخ :