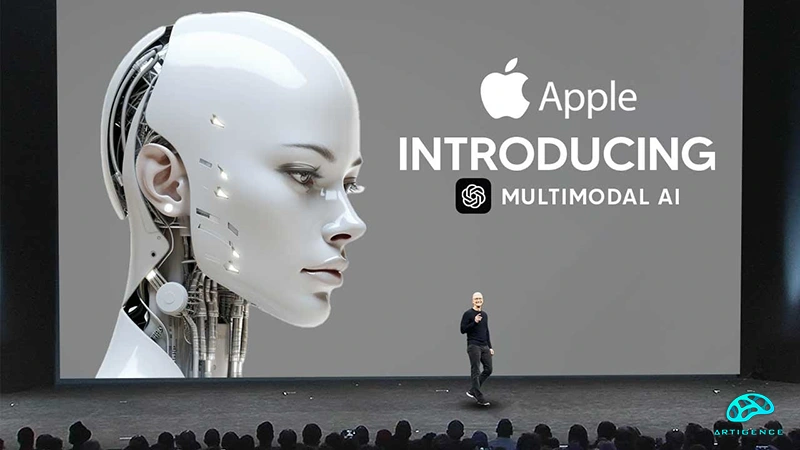

محققان اپل روش جدیدی را برای آموزش سریع مدلهای زبان بزرگ (LLM) به کار گرفتهاند که میتواند سیستمهای یادگیری ماشینی انعطافپذیرتر و قدرتمندتر ایجاد کند. یک مقاله تحقیقاتی که اوایل این هفته توسط این شرکت در سایت تحقیقاتی arxiv.org ارسال شد، نشان داد که اپل از ترکیب دقیقی از زیرنویس تصویر، متن تصویر درهمآمیخته و دادههای فقط متنی برای آموزش LLMهای خود استفاده کرده است. ترکیبی از دادههای بصری و زبانی به مدلها این امکان را میدهد تا کارهایی مانند زیرنویس کردن هوشمندانه تصاویر یا استنباط معانی زبان طبیعی را انجام دهند. به عنوان بخشی از تحقیقات، مشخص شد که به کارگیری این روش در آموزش مدلهای هوش مصنوعی از طرف اپل تأثیر زیادی بر عملکرد مدل دارد. در یک نمونه، با استفاده از یک مدل MM1 با پارامتر 30 میلیاردی، مشخص شد که تواناییهای یادگیری قوی وجود دارد. این کشف به این معنی است که مدل میتواند استدلال چند مرحلهای روی تصاویر متعدد را به بهترین نحو انجام دهد. مدیرعامل اپل، تیم کوک اخیراً اذعان کرده است که این شرکت سالانه یک میلیارد دلار برای گنجاندن هوش مصنوعی در فناوریهای موجود خود هزینه میکند.

کوک گفت که این شرکت جزئیات کار مداوم خود در زمینه هوش مصنوعی را در اواخر امسال به اشتراک خواهد گذاشت. انتظار میرود اپل در ماه ژوئن در WWDC برخی از پیشرفتهای خود را اعلام کند. این شرکت در استفاده از فناوریهای مرتبط با هوش مصنوعی به رقبای خود نزدیک میشود. همچنین در حال توسعه روشهایی است که بتواند حریم خصوصی کاربر را حفظ کند و در عین حال تواناییهای یادگیری ماشینی خود را افزایش دهد. نگرانی برای حفظ حریم خصوصی و امنیت در رباتهای چت اخیر زیاد مورد توجه نبوده است و این موضوع کار اپل را سختتر میکند. علاقه اپل به آموزش چند مدل شبکههای عصبی منجر به عملکرد پیشرفتهای شده است که امکان استدلال چندمرحلهای را فراهم میکند. این نشان میدهد که این شرکت راهی برای پیشرفت سریع تواناییهای یادگیری ماشینی و همچنین ارائه قابلیتهای پیشرفته پیدا کرده است.

شاهین آقامعلی

شاهین آقامعلی

پاسخ :

arzsanj

1 سال پیشبلاخره اپل هم وارد بازی شد