• دانشمندان از روشهایی برای کاهش زمان آموزش مدلهای هوش مصنوعی در مقیاس بزرگ در پردازندههای گرافیکی AMD استفاده کردند.

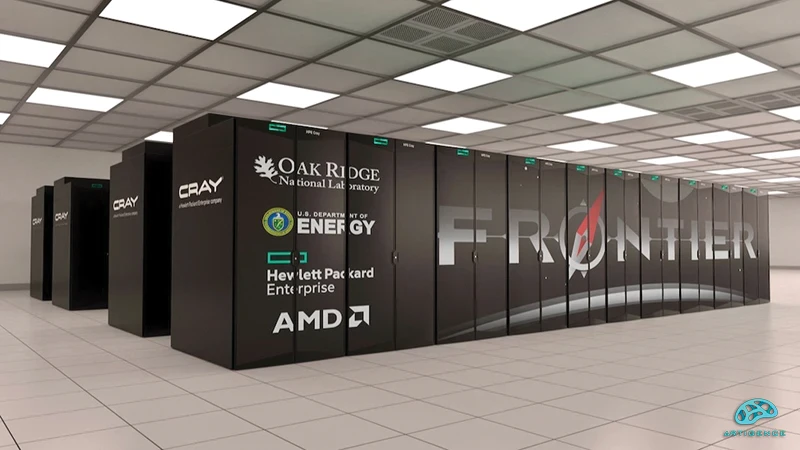

آموزش یک مدل زبان بزرگ به اندازه ChatGPT OpenAI معمولاً به یک ابر رایانه با سخت افزار قابل توجه نیاز دارد. دانشمندانی که روی قویترین ابررایانه جهان کار میکنند، تکنیکهای خلاقانهای برای آموزش مدلهای غولپیکر هوش مصنوعی با استفاده از سختافزارهای بسیار کمتر کشف کردند. در یک پژوهش دانشمندان آزمایشگاه ملی معروف Oak Ridge یک مدل یک تریلیون پارامتری را با استفاده از تنها چند هزار پردازنده گرافیکی در ابررایانه Frontier خود، قدرتمندترین ابرکامپیوتر غیر توزیعشده در جهان و یکی از تنها دو سیستم exascale در سطح جهان، آموزش دادند. آنها از بین 37888 پردازنده گرافیکی AMD موجود در Frontier از 3072 پردازنده گرافیکی برای آموزش مدل زبان بزرگ استفاده کردند. این بدان معناست که محققان مدلی تقریباً هم اندازه با ChatGPT با یک تریلیون پارامتر را تنها با استفاده از 8 درصد از قدرت محاسباتی Frontier آموزش دادند. تیم Frontier با استفاده از استراتژیهای آموزشی توزیع شده در معماری موازی به این موفقیت دست یافتند. با استفاده از تکنیکهایی مانند موازیسازی دادههای مختلط برای کاهش ارتباطات بین لایه گرهها و موازیسازی تانسور برای مدیریت محدودیتهای حافظه، این تیم توانست آموزش مدل را به طور مؤثرتری توزیع کند و از این طریق نیاز به بار پردازشی بالا را کاهش دهد. سایر تکنیکهایی که محققان برای هماهنگ کردن آموزش مدل به کار گرفتند شامل موازیسازی pipelineها برای آموزش مدل در طول گرههای مختلف در هر مرحله برای بهبود سرعت بود. نتایج، 100% بازده را برای مدلهای 175 میلیارد پارامتر و 1 تریلیون پارامتری نشان میداد. این پروژه همچنین به راندمان مقیاس پذیری قوی 89% و 87% برای این دو مدل دست یافت.

یک تریلیون پارامتر:

آموزش یک مدل زبان بزرگ با تریلیون پارامتر همیشه یک کار چالش برانگیز است. نویسندگان این مقاله میگویند که اندازه کامل این مدل حداقل 14 ترابایت است. در مقابل، یک پردازنده گرافیکی MI250X در Frontier، تنها 64 گیگابایت حافظه دارد. برای غلبه بر مشکلات حافظه، روشهایی مانند روشهایی که محققان مورد بررسی قرار دادند، باید توسعه یابند. مقاله آنها بیان میکند که تحقیقات آینده برای کاهش زمان آموزش برای سیستمهای مقیاس بزرگ باید شاهد بهبود در آموزش دستهای بزرگ با اندازههای کوچکتر باشد. محققان همچنین خواستار انجام بهینهسازیهای بیشتر در مورد پردازندههای گرافیکی AMD شدند. آنها نوشتند که بیشتر آموزشهای مدل در مقیاس بزرگ بر روی پلتفرمهایی انجام میشود که از پردازندههای گرافیکی Nvidia استفاده میکنند. در حالی که محققان طرحی را برای آموزش کارآمد LLM در پلتفرمهای غیر انویدیا ایجاد کردهاند. به همین خاطر باید عملکرد آموزشی را در پردازندههای گرافیکی AMD ارتقا داد. در پایان لازم به ذکر است که Frontier جایگاه خود را به عنوان قدرتمندترین ابررایانه در آخرین لیست Top500 حفظ کرده و ابررایانه Aurora مجهز به اینتل را پشت سر گذاشت است.

شاهین آقامعلی

شاهین آقامعلی

پاسخ :