هوش مصنوعی و یادگیری ماشین با سرعتی بیسابقه در حال تحول دنیای فناوری هستند. در قلب این تحول، الگوریتمهایی قرار دارند که میتوانند از دادهها الگو استخراج کرده و پیشبینیهای دقیقی ارائه دهند. یکی از قدرتمندترین الگوریتمها در این حوزه، Gradient Boosting است. این الگوریتم با ترکیب چند مدل ضعیف به یک مدل قدرتمند، دقتی شگفتانگیز در طبقهبندی، رگرسیون و رتبهبندی ایجاد میکند. در این مقاله به طور کامل با مفهوم Gradient Boosting، نحوه عملکرد، مزایا و معایب آن، کاربردهای صنعتی و تفاوت آن با سایر الگوریتمها آشنا خواهیم شد. در ادامه با آرتیجنس همراه باشید.

Gradient Boosting چیست؟

Gradient Boosting یا «تقویت گرادیانی» یک تکنیک در یادگیری ماشین است که از ترکیب مدلهای ساده و ضعیف (معمولاً درختهای تصمیمگیری) برای ساخت یک مدل قویتر استفاده میکند. این الگوریتم به صورت تدریجی و مرحله به مرحله، سعی میکند خطاهای مدلهای قبلی را اصلاح کند. ایده اصلی این است که هر مدل جدید، روی اشتباهات مدل قبلی تمرکز کند.

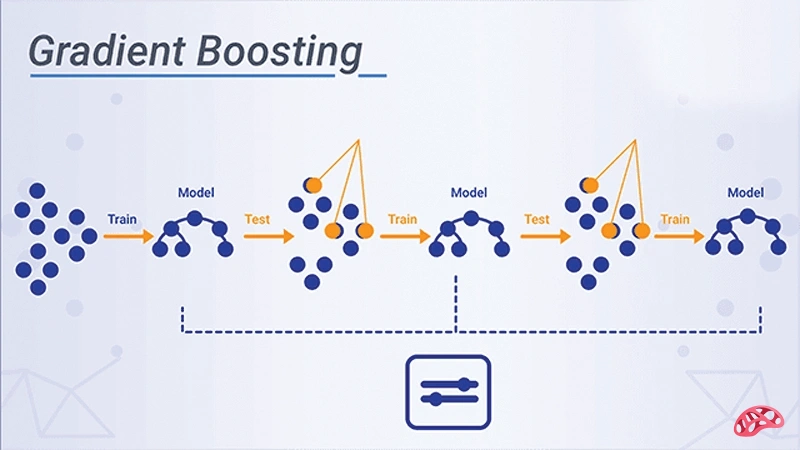

نحوه عملکرد Gradient Boosting چگونه است؟

فرآیند Gradient Boosting شامل چند مرحله کلیدی است:

1. شروع با یک مدل ساده: معمولاً درخت تصمیم کوچک.

2. محاسبه خطا: تفاوت بین پیشبینی مدل و مقدار واقعی.

3. یادگیری از گرادیان: مدل بعدی بر اساس گرادیان خطا آموزش میبیند.

4. بهروزرسانی مدل نهایی: مدل جدید به مدلهای قبلی اضافه میشود.

5. تکرار فرآیند: این مراحل چندین بار تکرار میشوند تا خطا به حداقل برسد.

در واقع، این الگوریتم سعی میکند با حرکت در جهت عکس گرادیان خطا (همانند بهینهسازی)، عملکرد کلی سیستم را بهبود دهد.

چرا Gradient Boosting اینقدر محبوب است؟

یکی از دلایل محبوبیت Gradient Boosting در بین دانشمندان داده و مهندسان یادگیری ماشین، دقت بالای آن در مسائل پیچیده است. برخلاف برخی الگوریتمها که نیاز به پیشپردازش پیچیده دارند، مانند الگوریتم ماشین بردار پشتیبان، Gradient Boosting به خوبی با دادههای واقعی و حتی ناقص سازگار است. همچنین این الگوریتم در رقابتهای بزرگ علم داده مانند Kaggle نقش مهمی ایفا کرده و پایهگذار مدلهایی مانند XGBoost و LightGBM شده است که برتری خود را بارها به اثبات رساندهاند.

مزایای استفاده از الگوریتم Gradient Boosting

• دقت بالا: در اغلب موارد عملکرد بهتری نسبت به الگوریتمهای کلاسیک دارد.

• قابلیت انعطاف: قابل استفاده برای طبقهبندی، رگرسیون و رتبهبندی.

• مدیریت دادههای نامنظم: با دادههای گمشده یا نویزی نیز خوب کار میکند.

• عدم نیاز به نرمالسازی دادهها: برخلاف شبکههای عصبی یا SVM، نیازی به مقیاسبندی ویژگیها ندارد.

معایب Gradient Boosting که باید بدانید

• زمان آموزش طولانی: به دلیل ساخت مدلهای پیاپی، آموزش زمانبر است.

• حساس به پارامترها: تنظیم پارامترهایی مانند نرخ یادگیری یا عمق درختها اهمیت بالایی دارد.

• ریسک بیشبرازش (Overfitting): در صورت تنظیم نادرست، مدل ممکن است بیش از حد به دادههای آموزش وابسته شود.

• قابلیت تفسیر محدود: با افزایش تعداد مدلها، تحلیل رفتار کلی مدل سختتر میشود.

کاربردهای Gradient Boosting در صنعت

الگوریتم Gradient Boosting در بسیاری از صنایع استفاده میشود:

• بانک و فینتک: برای پیشبینی ریسک اعتباری یا تشخیص تقلب.

• بازاریابی دیجیتال: پیشبینی نرخ تبدیل مشتریان، توصیهگر محصولات.

• پزشکی: پیشبینی بیماریها یا تحلیل نتایج آزمایشها.

• تشخیص تقلب: در سیستمهای پرداخت آنلاین و بیمه.

• مالی و سرمایهگذاری: تحلیل سریهای زمانی، پیشبینی قیمت بازار.

XGBoost، LightGBM و CatBoost؛ مشتقات Gradient Boosting

طی سالهای اخیر، نسخههای بهینهتر و سریعتری از Gradient Boosting توسعه یافتهاند که هر کدام ویژگیها و مزایای خاصی دارند:

• XGBoost: سریع، قابل تنظیم و مقاوم در برابر بیشبرازش؛ انتخاب اول در مسابقات دادهکاوی.

• LightGBM: نسخهای سبکتر از XGBoost که برای دادههای بزرگ بسیار سریعتر عمل میکند.

• CatBoost: مناسب برای دادههای دستهای (Categorical)، بدون نیاز به پیشپردازش پیچیده.

این ابزارها به شکل متنباز عرضه شدهاند و به راحتی با زبانهای برنامهنویسی مانند Python و R قابل استفاده هستند.

تفاوت Gradient Boosting با Random Forest

اگرچه هر دو الگوریتم بر پایه درخت تصمیم عمل میکنند، تفاوتهای مهمی دارند:

• در Random Forest، درختها به صورت موازی ساخته میشوند و از میانگین نتایج استفاده میشود.

• در Gradient Boosting، درختها به صورت ترتیبی ساخته میشوند و هر درخت خطای قبلی را جبران میکند.

• Gradient Boosting معمولاً دقت بیشتری دارد اما بیشتر در معرض بیشبرازش قرار میگیرد.

نکاتی برای بهینهسازی Gradient Boosting

برای داشتن عملکرد بهتر در الگوریتم Gradient Boosting، این نکات را رعایت کنید:

• نرخ یادگیری را پایین انتخاب کنید (مثلاً ۰.۱ یا کمتر) و در عوض تعداد مراحل را افزایش دهید.

• از روشهای اعتبارسنجی متقابل (Cross-validation) استفاده کنید تا از بیشبرازش جلوگیری شود.

• پارامترهایی مانند عمق درخت، تعداد مرحله، و نوع از دست دادن (Loss Function) را با دقت تنظیم کنید.

• ویژگیهای کماثر را حذف یا ادغام کنید تا مدل سبکتر و سریعتر شود.

نتیجهگیری

الگوریتم Gradient Boosting یکی از ستونهای اصلی در مدلسازی دقیق و هوشمند در عصر داده است. با وجود پیچیدگیهای آن، اگر به درستی پیادهسازی و تنظیم شود، نتایجی خارقالعاده ارائه میدهد. چه در تحلیل مالی باشید، چه در پزشکی یا تجارت الکترونیک، این الگوریتم میتواند یکی از بهترین ابزارهای شما در پیشبینی و تصمیمگیری هوشمند باشد.

منبع مقاله:

شاهین آقامعلی

شاهین آقامعلی

پاسخ :